「引用は出典リンク必須・必要最小限」「FAQ全文転載・図表転載は禁止」「社内資料/研修利用は要連絡」

バックナンバーはこちら

はじめに

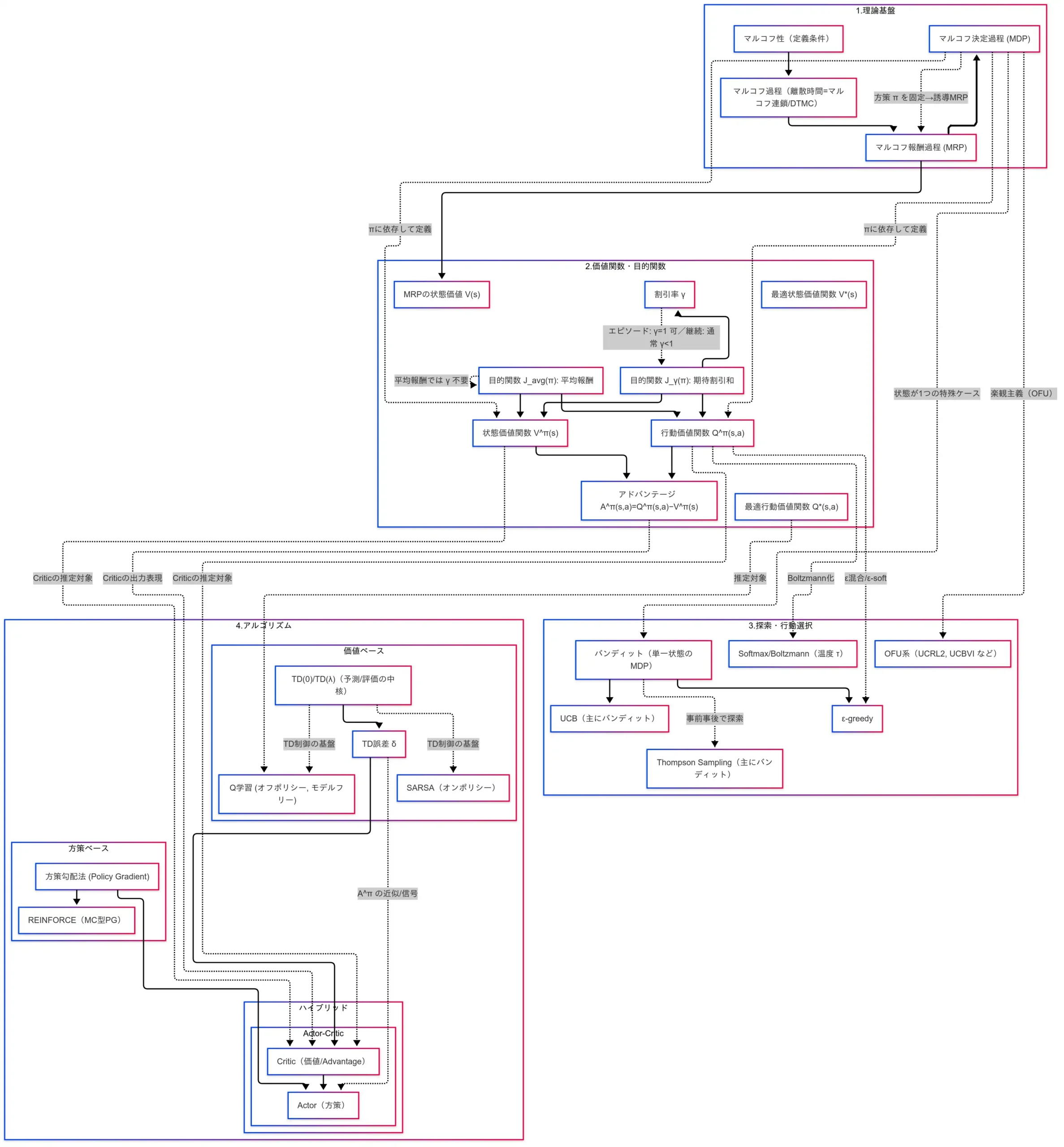

本稿は「G検定対策 究極カンペをつくろう」シリーズ第7作目の内容を、ブログ用に再構成したものである。前回は DQN や PPO などの 深層強化学習 を概観し、アルゴリズムの進化と応用事例を幅広く確認した。一方で、それらを正しく位置づけるためには、まず 強化学習の土台となる基礎 を明確にしておく必要がある。

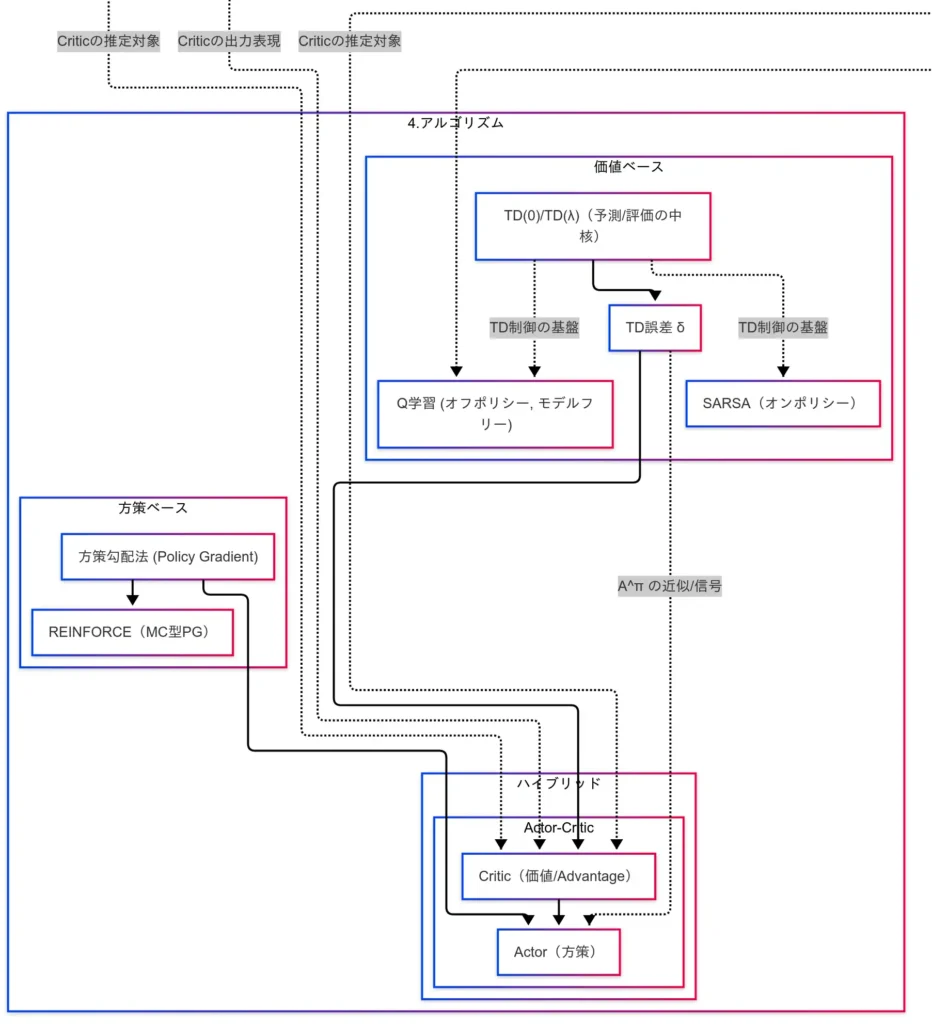

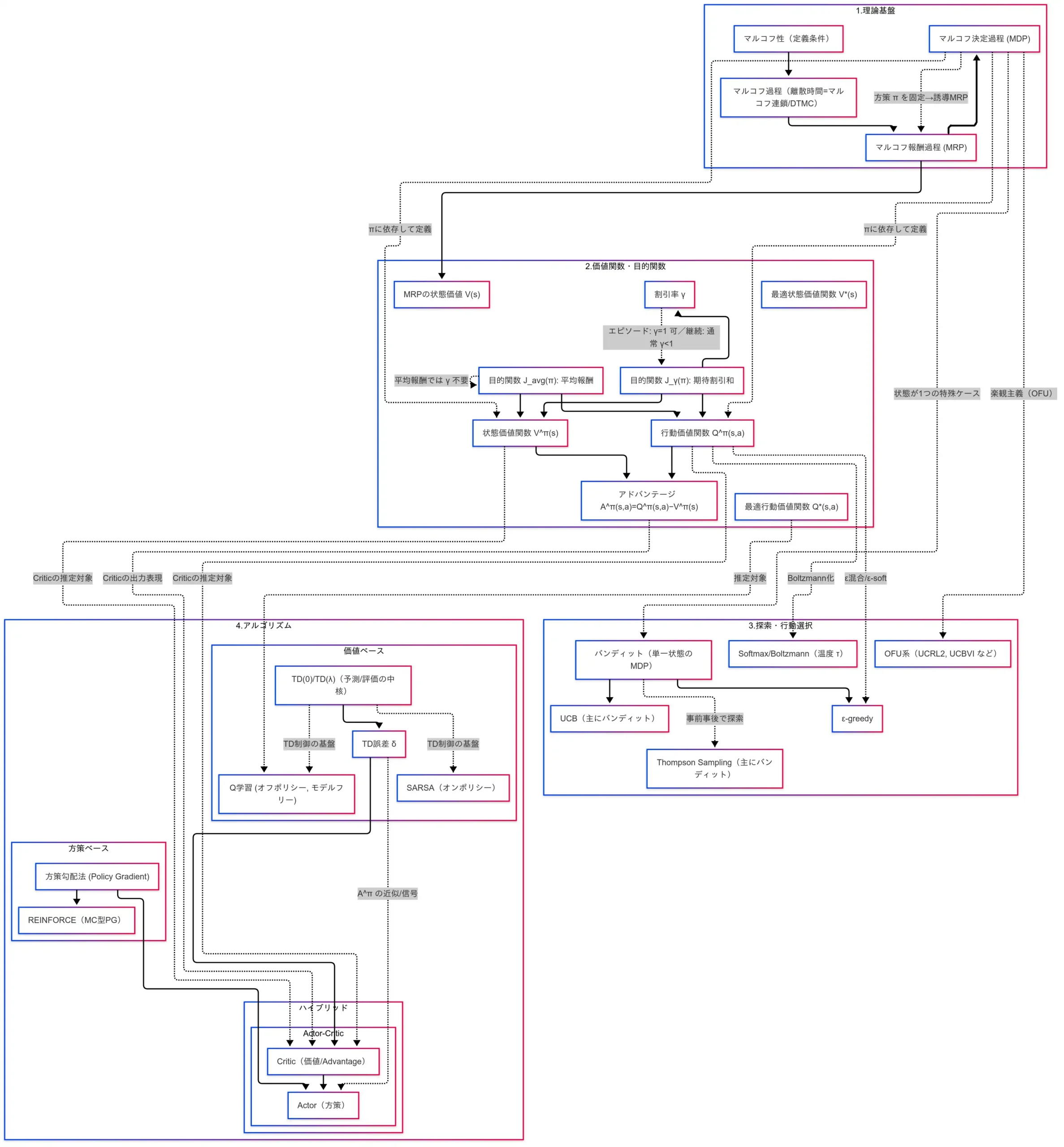

そこで本稿では、深層部分に踏み込む前段として、マルコフ決定過程(MDP)、価値関数、探索、 そして 基本アルゴリズム といった、G検定でも問われやすい基礎概念を整理する。読者が用語を個別に暗記するのではなく、 概念間のつながり を掴めるよう、動画と同様に 因果関係図 を手がかりとして解説を進める方針である。数式的な語彙が多く登場するが、図を介して全体像を俯瞰することで、学習の沼に迷い込むことなく、重要点を筋道立てて理解できるはずである。

動画シリーズ

G検定の究極カンペ関連動画の再生リスト

説明内容

本稿で解説する範囲は次の四点である。

- 理論基盤(マルコフ性、MDP)

- 価値関数・目的関数

- 探索と行動選択

- 代表的アルゴリズム(Q 学習、SARSA、方策勾配、Actor-Critic)

まず強調したいのは、 「マルコフ性」「マルコフ過程」「マルコフ決定過程(MDP)」は名称が似ているが別概念 である点である。三者は強く関連しつつも役割が異なるため、 関連づけて理解しつつ明確に識別する ことが重要である。本稿では、これらの概念の階層関係を 因果関係図 に対応づけ、用語の羅列ではなく“つながり”として把握できるように整理する。

この基礎を押さえることで、後続の 価値関数($V,Q,A$)や 目的関数($J$)、ならびに 探索戦略(ε-greedy、Softmax、UCB、Thompson、OFU) の位置づけが明快になり、最終的に Q学習/SARSA(価値ベース)・REINFORCE(方策ベース)・Actor-Critic(ハイブリッド) へと自然に接続できるようになるはずである。以降、理論基盤から順に、図を参照しながら要点を積み上げていく。

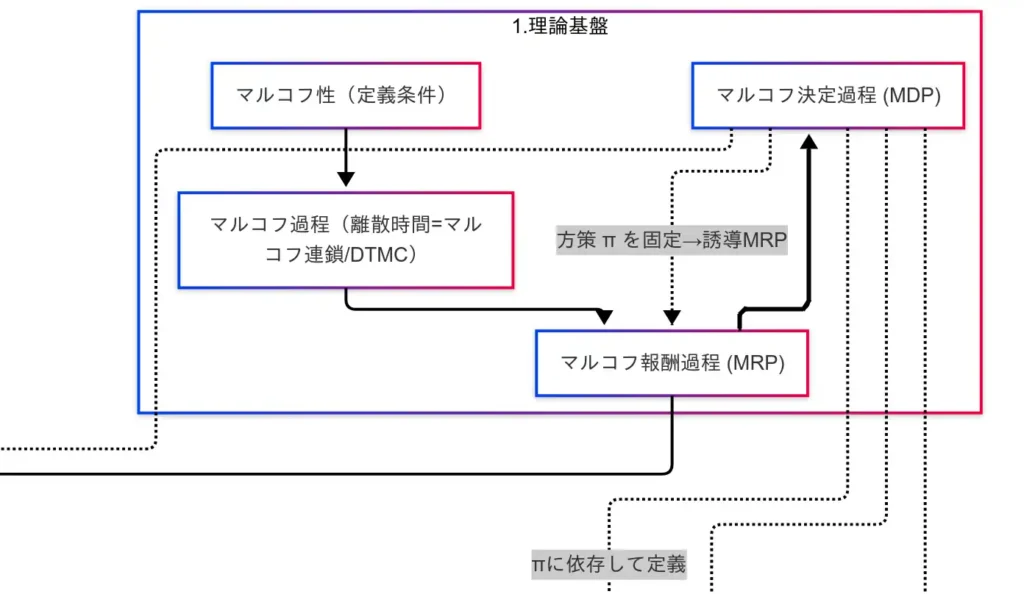

理論基礎

本節では、強化学習の数理モデルの土台を確認する。要点は マルコフ性 → マルコフ過程(DTMC) → マルコフ報酬過程(MRP) → マルコフ決定過程(MDP) → 誘導MRP の流れである。

マルコフ性

マルコフ性 とは、「次の状態は いま の状態のみに依存する」という性質である。履歴全体ではなく現在が十分統計量になる点が本質である。行動を明示しない場合の遷移は

$$

P(s^\prime|s)

$$

と表す。直感的には「今だけ見ればよい」という可換な簡約の効き目である。

マルコフ過程(DTMC)

マルコフ性を前提に、状態が時間とともに遷移する連鎖を マルコフ過程(離散時間マルコフ連鎖; DTMC) と呼ぶ。

$$

S_0\xrightarrow{P(s_1|s_0)}s_1\xrightarrow{P(s_2|s_1)}x_2\longrightarrow \dots

$$

ここでは報酬は未導入であり、「状態が推移する仕組み」をまず定式化する段階である。

マルコフ報酬過程(MRP)

DTMC に 報酬 を付与したものが MRP である。状態(あるいは遷移)に対して報酬を定義し、累積報酬の評価(後述の価値関数)へ橋渡しを行う。「ただ移動する」から「移動してご褒美を得る」に拡張した形である。

マルコフ決定過程(MDP)

さらに 行動 を導入した枠組みが MDP である。強化学習の中心モデルであり、定義は次の 5 要素の組で与える。

$$

\text{MDP} = \langle S,A, P, R, \gamma \rangle

$$

- $P(s’|s,a)$:状態遷移確率

- $R(s,a)$:報酬関数

- $\gamma$:割引率

- 行動選択ルールとして方策 $\pi(a|s)$ を用いる

ここで初めてエージェントが「どう動くか」を選択できるようになり、学習の対象が明確化する。

誘導MRP(MDPからの還元)

MDP において 方策 $\pi$ を固定すると、行動は確率的に定まるため、実質的に「状態と報酬だけの世界」へ還元できる。これを 誘導MRP と呼ぶ。

すなわち、

$$

MDP + \pi \Rightarrow MRP

$$

であり、「行動の自由」を封印した縛りプレイの比喩は本質を突いている。以降の価値関数の定義やベルマン方程式は、この誘導MRPの視点から導入すると整理が良い。

以上が理論基盤である。次節では、このモデル上で “価値”をどう定義するか($V,Q,A$ と目的関数$J$)を確認する。

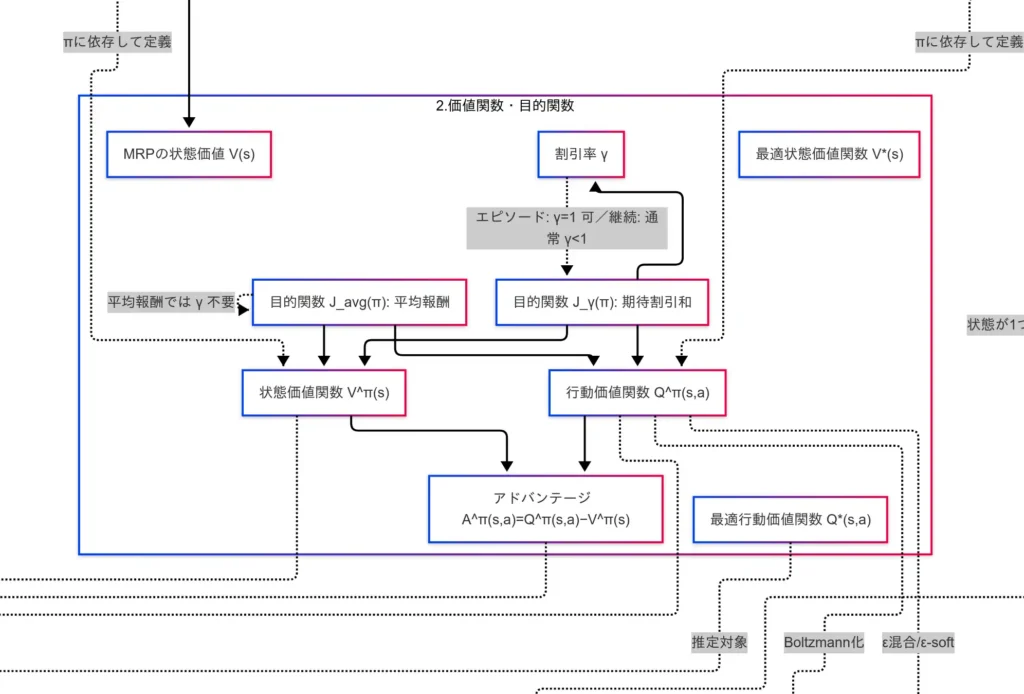

価値関数・目的関数

本節では、強化学習における「評価」の枠組みを定義する。すなわち、状態や行動がどれほど良いか を数値化する関数群(価値関数)と、 方策そのものの良さ を測る目的関数である。式と直感を対にして把握することが肝要である。

状態価値関 $V^\pi(s)$

方策 $\pi$ に従うとき、状態 $s$ から得られる将来報酬の期待値である。

$$

V^\pi(s)=\mathbb{E}_\pi\bigg[\sum_{t=0}^\infty\gamma^t R_{t+1}\bigg|S_0=s\bigg]

$$

- 「その状態にいること自体の良さ」を表す量である。

- 将来報酬を割引率 $\gamma\in[0,1]$ で減衰させて合算する。

行動価値関数 $Q^\pi(s,a)$

状態 $s$ で行動 $a$ を選択し、その後 $\pi$ に従うときの将来報酬の期待値である。

$$

Q^\pi(s,a)=\mathbb{E}_\pi\bigg[\sum_{t=0}^\infty\gamma^t R_{t+1}\bigg|S_0=s,A_0=a\bigg]

$$

- 行動まで含めて評価するため、行動選択 の比較に直接用いられる。

アドバンテージ $A^\pi(s,a)$

行動が状態平均よりどれほど良いかを示す差分である。

$$

A^\pi(s,a)=Q^\pi(s,a)-V^\pi(s)

$$

- 「その一手が平均よりどれだけ上ぶれるか」という直感で捉えると良い。

最適価値関数

最適方策を前提にした価値である。

$$

V^*(s)=\max_\pi V^\pi(x),\ \ \ Q^*(s,a)=\max_\pi Q^\pi(s,a)

$$

- 以降の学習アルゴリズムは、この最適値(あるいはそれに到達する方策)を目指す。

目的関数(方策の良さ)

方策 $\pi$ 自体の評価尺度であり、学習のターゲットである。

期待割引和 $J_\gamma(\pi)$

$$

J_\gamma(\pi)=\mathbb{E}_\pi\bigg[\sum_{t=0}^\infty\gamma^t R_{t+1}\bigg]

$$

- エピソード型では $\gamma=1$ も選択可能である。

- 継続タスクでは通常 $\gamma<1$ として将来を割り引く。

平均報酬 J_{\text{avg}}(\pi)

$$

J_{\text{avg}}(\pi)=\lim_{n\to\infty}\frac{1}{n}\mathbb{E}_\pi\bigg[\sum_{t=0}^{n-1}\gamma^t R_{t+1}\bigg]

$$

- 定常的な長期運用を想定する指標であり、割引率を用いない 点が特徴である。

受験上の要点

- $V,Q,A$ の役割分担を明確化すること(状態のみ/行動込み/差分)である。

- 最適価値 $V^*,Q^*$ は「最良方策の下での価値」であり、推定対象として頻出である。

- 目的関数の二系統(割引和と平均報酬)の違いと、$\gamma$ の意味(未来重視度のノブ)を取り違えないことが重要である。

以上で「価値をどう定義し、何を最大化するか」の枠組みが整う。次節では、この枠組みの上で 探索と行動選択 をどのように設計するかを述べる。

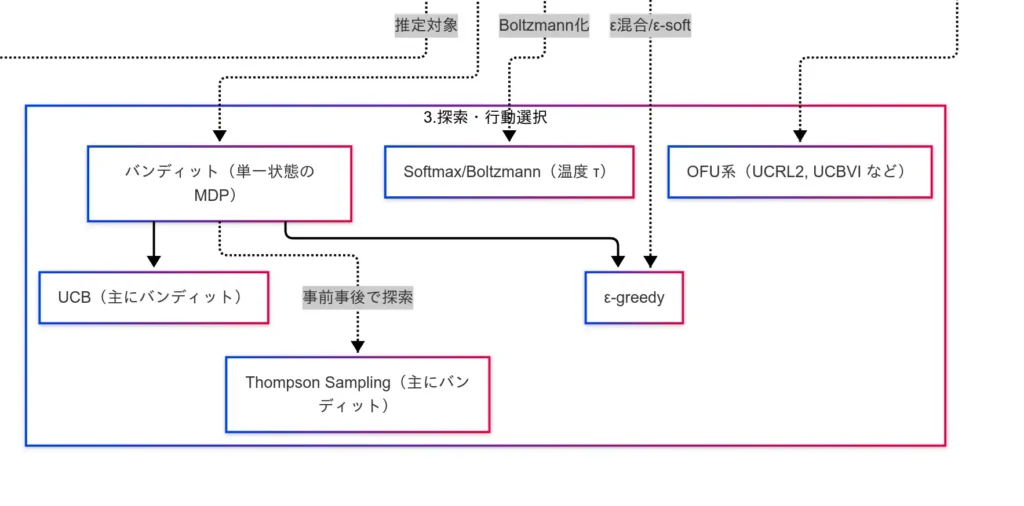

探索と行動選択

本節では、エージェントが「どのように行動を選ぶか」を扱う。鍵となるのは 探索と活用(exploration-exploitation)のトレードオフ である。すなわち、既知の最善を用いて確実な報酬を得るか(活用)、未知の行動を試してより良い選択肢を発見するか(探索)を、状況に応じて両立させる設計である。

バンディット問題(単一状態の MDP)

状態が一つだけの MDP を想定し、複数の腕(行動)のうちどれを引くかを学ぶ簡約モデルである。探索戦略の多くはまずバンディットで導入され、MDP へ拡張される。

ε-greedy(ε‐貪欲)

既知の最善行動を確率 $1-\epsilon$ で選び、確率 $\epsilon$ で一様ランダムに探索する単純かつ強力な基準である。

$$

\pi(a|s) = \begin{cases}

\displaystyle 1-\epsilon+\frac{\epsilon}{|A|}\ \ &\ &\text{if}\ a=\arg\max_{a^\prime}Q(s,a^\prime)\\

\displaystyle\frac{\epsilon}{|A|}\ &\ &\text{otherwise}

\end{cases}

$$

$\epsilon$ の スケジューリング(例:線形減少、指数減衰) により、学習初期は探索を厚く、終盤は活用を重くする設計が一般的である。

Softmax / Boltzmann 方策

行動価値を確率に変換して抽選する方法である。温度 $\tau>0$ によりランダム度を調整する。

$$

\pi(a|s) =\frac{\exp(Q(s,a)/\tau)}{\sum_{a^\prime}\exp(Q(s,a^\prime)/\tau)}

$$

- $\tau\downarrow0$ で貪欲化、$\tau\uparrow0$ でほぼ一葉選択となる。

- 値の差に滑らかに反応するため、ε-greedy よりも微妙な差を反映しやすい。

UCB(Upper Confidence Bound)

推定値に 不確実性(信頼上限) を加点して選ぶ戦略である。典型例として UCB1 は腕 $a$ を

$$

\underbrace{\hat{\mu}_a}_{\text{経験平均}} + \underbrace{c \sqrt{\frac{\ln t}{n_a}} }_{\text{不確実性(探索ボーナス)}}

$$

でスコアリングし、最大の腕を選ぶ。ここで $t$ は総試行数、$n_a$ は腕 $a$ の試行回数である。

- 試行回数が少ない腕は不確実性が大きく、理にかなった探索 が自動で促進される。

Thompson Sampling

腕の報酬分布に事前分布を置き、観測により事後を更新しつつ、事後からサンプリングしたパラメータで最善腕を選ぶ ベイズ的戦略である。

- 不確実性の扱いが自然で、実装も簡潔であり、経験的性能が高いことが多い。

OFU 系(Optimism in the Face of Uncertainty)

不確実な部分を 楽観的に評価 して方策を選ぶ立場である。MDP 全体に拡張した代表例に UCRL2、UCBVI などがある。

- 遷移確率や報酬の推定区間の「上側」を用いて最適化することで、探索を理論的に保証する枠組みである。

受験上の要点

- バンディット=単一状態の MDP という位置づけを押さえること。

- ε-greedy は簡便で強力、Softmax は温度で滑らかに制御、UCB/Thompson は不確実性を明示的に扱う。

- OFU は MDP 全体での探索保証の文脈で登場(UCRL2/UCBVI の名称を把握しておく)。

以上で探索と行動選択の基礎が整った。次節では、これらの上に立つ 代表的アルゴリズム(Q 学習、SARSA、方策勾配、Actor-Critic)を確認する。

代表的アルゴリズム

本節では、強化学習の実装で頻出となる代表的手法を概観する。土台は TD 学習であり、その上に SARSA/Q 学習(価値ベース)、REINFORCE(方策ベース)、そして両者を統合する Actor-Critic が位置づく構図である。

TD 学習(Temporal Difference)

将来の最終結果を待たず、途中推定で更新できる逐次学習である。更新式は次のとおりである。

$$

V(s)\leftarrow V(s)+\alpha[R_{t+1}+\gamma V(s^\prime)-V(s)]

$$

角括弧内は TD 誤差 $\delta$ であり、「予測と実測のズレ」を表す信号である。以降の多くの手法で、この $\delta$ が更新の芯として機能する。

SARSA(オンポリシー)

実際に選んだ次行動 $\alpha^\prime$ を用いて更新する、方策一貫性重視の制御である。

$$

Q(s,a)\leftarrow Q(s,a)+\alpha[R_{t+1}+\gamma Q(s^\prime,a^\prime)-Q(s,a)]

$$

オンポリシー であるため、学習中の方策に忠実で安全側に働きやすい一方、収束速度は遅くなる場合がある。

Q 学習(オフポリシー)

次状態での 最良行動価値 を仮定して更新する、オフポリシー制御である。

$$

Q(s,a)\leftarrow Q(s,a)+\alpha[R_{t+1}+\gamma \max_{\alpha^\prime}Q(s^\prime,a^\prime)-Q(s,a)]

$$

理論的には最適方策へ収束しやすいが、探索が不足すると推定が偏る危険がある。探索戦略(ε-greedy 等)との併用設計が実務上の肝である。

方策勾配法:REINFORCE(モンテカルロ型)

価値を介さず 方策そのもの のパラメータ $\theta$ を最適化する手法である。

$$

\theta\leftarrow\theta+\alpha G_t \nabla_\theta\log \pi_\theta(a|s)

$$

ここで $G_t$ は時刻 $t$ 以降の累積報酬である。エピソード完了後に更新する モンテカルロ型 であり、分散が大きくなりやすいため、実務ではベースライン(例:$V(s)$)減算による分散低減が併用されることが多い。

Actor-Critic(ハイブリッド)

Actor が方策を、Critic が価値(またはアドバンテージ)を担当する統合手法である。Critic が算出する TD 誤差 $\delta$ を学習信号として Actor を更新する。

$$

\begin{align}

\text{Critic}&: V(s)\leftarrow V(s)+\alpha\delta\\

\text{Actor}&: \theta\leftarrow\theta+\beta\delta\nabla_\theta\log\pi_\theta(a|s)

\end{align}

$$

オンライン更新が可能で、方策勾配の表現力と TD の効率性を兼ね備える点が利点である。直感的には Actor=プレイヤー/Critic=解説者 という役割分担で捉えると良い。

受験上の要点

- SARSA=オンポリシー、Q 学習=オフポリシー を取り違えないこと。

- TD 誤差 $\delta$ が多手法に共通する更新信号である点を把握すること。

- REINFORCE はモンテカルロ型で分散が大きくなりやすい(ベースラインで低減)こと。

- Actor-Critic は価値推定と方策更新のハイブリッドであり、実用性が高いこと。

以上で代表的アルゴリズムの骨格が揃う。次節では、これまでの要点を因果関係図に沿って総括する。

まとめ

本稿では、因果関係図に沿って強化学習の土台を俯瞰した。まず 理論基盤 として、 マルコフ性 → マルコフ過程(DTMC) → MRP → MDP → 誘導MRP の階段を確認した。MDP が中心モデルであり、方策 $\pi$ を固定すれば MRP に還元されるという対応関係が要点である。すなわち「性質 → 過程 → 報酬 → 行動」という拡張の流れを押さえることが、後続の理解を支える。

次に 価値関数・目的関数 として、$V^\pi(s)$(状態のみ)、$Q^\pi(s,a)$(行動込み)、$A^\pi(s,a)=Q^\pi-V^\pi$(差分)の役割分担を整理し、最適版 $V^,Q^$ の位置づけを確認した。目的関数は 期待割引和 $J_\gamma$ と 平均報酬 $J_{\text{avg}}$ の二系統であり、割引率 $\gamma$ は「未来をどれだけ重視するか」のノブである。

探索と行動選択では、バンディット(単一状態の MDP)を土台に、ε-greedy(単純・堅実)、Softmax/Boltzmann(温度で滑らか制御)、UCB(信頼上限で理性的探索)、Thompson Sampling(ベイズ的探索)、OFU 系(UCRL2/UCBVI)を概観した。いずれも 探索‐活用トレードオフ をどう設計するかが核である。

最後に 代表的アルゴリズム として、TD 学習(逐次更新・TD 誤差 $\delta$)、SARSA(オンポリシー)、Q 学習(オフポリシー)、REINFORCE(方策勾配・MC 型)、Actor-Critic(価値推定×方策更新のハイブリッド)を整理した。直感的には Actor=プレイヤー/Critic=解説者 と捉えると運用イメージが掴みやすい。

以上の対応関係を図で往復できれば、用語の断片が線で結び直され、問題文の意図も読み取りやすくなるはずである。次の学習ステップとして、DQN、A2C/A3C、TRPO、PPO、分布型 DQN(Categorical/Rainbow)、NoisyNet、オフライン RL、RLHF といった発展系を、本稿の“土台”にマッピングして復習することを推奨する。

- 理論基盤は マルコフ性 → マルコフ過程 → MRP → MDP → 誘導MRP の階段であり、MDP が中心モデルである。

- 価値は $V,Q,A$ と最適値 $V^*,Q^*$、目的関数は $J_\gamma,J_{\text{avg}}$ で、$\gamma$ は未来重視度のノブである。

- 探索と行動選択は ε-greedy/Softmax/UCB/Thompson/OFU を使い分け、実装は TD→SARSA/Q 学習、REINFORCE、Actor-Critic を軸に据えるべきである。

「引用は出典リンク必須・必要最小限」「FAQ全文転載・図表転載は禁止」「社内資料/研修利用は要連絡」

バックナンバーはこちら

深層学習教科書 ディープラーニング G検定(ジェネラリスト)公式テキスト 第3版

徹底攻略ディープラーニングG検定ジェネラリスト問題集 第3版 徹底攻略シリーズ

ディープラーニングG検定(ジェネラリスト) 法律・倫理テキスト

コメント