検定対策のまとめ記事はこちら。

https://www.simulationroom999.com/blog/jdla-deep-learning-for-general-2020-1/

はじめに

G検定超入門 とりあえず公式例題を解いてみる#2

の続き。

本記事では全18問中の

ディープラーニングの手法 5問

ディープラーニングの研究分野 2問

の合計7問まで。

G検定 公式例題

その他の例題

人工知能をめぐる動向 2問、人工知能分野の問題 2問の計4問

機械学習の具体的手法 4問、ディープラーニングの概要 3問の計7問

ディープラーニングの手法(1問目)

問題

Q. 以下の文章を読み、空欄に最もよく当てはまる選択肢を語群の中から1つずつ選べ。

G検定の例題(https://www.jdla.org/certificate/general/issues/)

画像認識の国際的なコンペティションのひとつに、ILSVRC(ImageNet Large Scale Visual Recognition Competition)がある。ここで、2012年にCNNのモデルである(ア)が優勝を飾った。それからというもの、続けざまにCNNのモデルが高い成果を上げている。2014年にはインセプションモジュールという構造を利用した(イ)が優勝し、(ウ)もまたそれに迫る優秀な功績を収めた。また、2015年には残差学習という深いネットワークの学習を可能にした(エ)がそれぞれ優勝している。

1. AlexNet

2. ElmanNet

3. GoogLeNet

4. ImageNet

5. LeNet

6. ResNet

7. VGG

8. WaveNet

解答

(ア)1

(イ)3

(ウ)7

(エ)6

解説

アについて

ILSVRC2012にトロント大学のジェフリー・ヒントンのCNNモデルであるAlexNetが、

2位と大差をつけて一位となり、

ディープラーニングの研究が一気に注目を浴びることになっています。

イについて

インセプションモジュールといえばGoogLeNet。

複数の畳み込み層を並列に持つネットワークを1モジュールとして深層化しているのが特徴。

ウについて

GoogLeNetに次いで2位となったのがVGG。

なぜ2位のモデルまで問われるかというと、VGGはシンプルな構成なためか論文でたびたび登場する。

そういった背景からCNNモデルの歴史としては存在を無視できないモデルとなる。

エについて

残差学習といえばResNet。

スキップコネクションという機構を入れ込み、勾配消失問題を抑制している。

ディープラーニングの手法(2問目)

問題

Q. 以下の文章を読み、空欄に最もよく当てはまる選択肢を各語群の中から1つずつ選べ。

G検定の例題(https://www.jdla.org/certificate/general/issues/)

ニューラルネットワークにおいて、初期は中間層で(ア)が活性化関数として使用されていた。しかし、(イ)ために、層を深くすると学習に用いる勾配がほぼ0になってしまうという問題が起こった。これは、勾配消失問題と呼ばれる重要な問題である。

ディープラーニングで活性化関数として用いられることが多い(ウ)は(ア)と比較してこの問題が生じにくい。また、計算量が少なく済むことも特徴的である。一方で、(エ)を用いることで活性化関数として(ア)を用いた場合でも学習が早く進むことが知られている。

(ア)

1. ステップ関数

2. ReLU

3. sigmoid関数

4. softmax関数

(イ)

1. 負の値を入力された場合に出力が一定になってしまう

2. 出力の平均値が0、標準偏差が1にならない

3. 関数に微分不可能な点が存在する

4. 入力の絶対値が大きいと、出力がほぼ一定になってしまう

(ウ)

1. ステップ関数

2. ReLU

3. sigmoid関数

4. softmax関数

(エ)

1. Dropout

2. Batch Normalization

3. Regularization

4. Weight Decay

解答

(ア)3

(イ)たぶん4

(ウ)2

(エ)2

解説

アについて

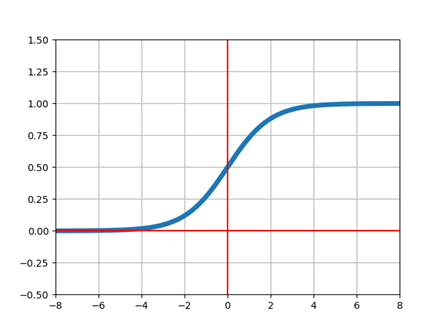

ニューラルネットワークの初期に使用されていた活性化関数はsigmoid関数。

sigmoid関数

イについて

sigmoid関数の特徴に合うのは2,4。

問題文に「層を深くすると学習に用いる勾配がほぼ0」とあるところから、

おそらく4。

sigmoid関数の出力は必ず1未満になることから、層を重ねるごとに0方向に収束しやすくなる。

また、選択肢の先読みになってしまうが、(ウ)に入るのが、ReLUなので、2が答えだとすると問題文全体の辻褄が合わなくなってしまう。

(ReLUも2の性質を持っている)

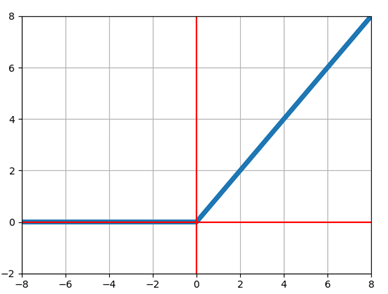

ウについて

選択肢の中でsigmoid関数を比較として勾配消失問題を抑制しているのはReLU関数。

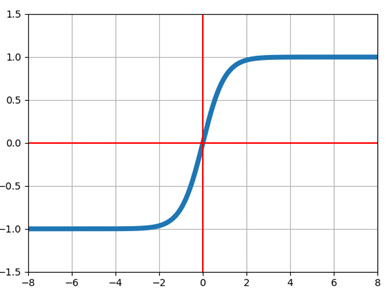

選択肢にはないが、tanh関数も条件によっては該当する。

ReLU関数

tanh関数

エについて

「学習が早く進む」ことからBatch Normalization。

その他の選択肢は過学習抑制に効果のあるもの。

ディープラーニングの手法(3問目)

問題

Q. 次の文章の(A)、(B)の組み合わせとして、最も適しているものを1つ選べ。

G検定の例題(https://www.jdla.org/certificate/general/issues/)

時系列データの分析には、もともと( A )が最も適していると考えられていたが、時系列データのひとつである音声処理の分野では( B )が非常に高い精度を記録している。

1. (A)リカレントニューラルネットワーク (B)畳み込みニューラルネットワーク

2.(A)リカレントニューラルネットワーク (B)Autoencoder

3. (A)畳み込みニューラルネットワーク (B)リカレントニューラルネットワーク

4. (A)畳み込みニューラルネットワーク (B)Autoencoder

5. (A)Autoencoder (B)畳み込みニューラルネットワーク

6. (A)Autoencoder (B)リカレントニューラルネットワーク

解答

きっと1

解説

完全に消去法。

まず時系列データの分析に最も適していると言われているものは

リカレントニューラルネットワーク(RNN)、畳み込みニューラルネットワーク(CNN)、Autoencoderと問われれば、RNNとなる。

CNNもあり得るが、問題の前後関係上でRNN。

そして、音声処理の分野で効果を発揮したのが、

CNNかAutoencoderかと問われればCNN。

音声スペクトルに対してCNNを使用して分類することがある。

また、音声時系列データに対して1D-CNNを使用するパターンも想定される。

Autoencoderでも何かしらできるはずだが、

Autoencoderの性質としては異常検知、クラスタリングになる。

よって、RNNで実現していたものの置き換えという意味では性質が異なる。

ディープラーニングの手法(4問目)

問題

Q. 以下の文章の空欄に最も適切に当てはまる選択肢を、各語群の中からそれぞれひとつずつ選べ。

G検定の例題(https://www.jdla.org/certificate/general/issues/)

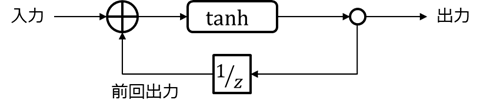

RNN(Recurrent Neural Network)は、(ア)を扱うために開発された。それまでのフィードフォワードニューラルネットワークと比較して特徴的なのは、入力データに加え(イ)を隠れ層に入力する(ウ)構造を取り入れたことである。

(ア)

1. 周期データ

2. 累積データ

3. 連鎖データ

4. 系列データ

(イ)

1. 前回の入力

2. 前回の中間層の状態

3. 過去のすべての入力

4. 過去のすべての中間層の状態

(ウ)

1. 再帰

2. 畳み込み

3. 逆伝播

4. 正則化

解答

(ア)4

(イ)たぶん2

(ウ)1

解説

アについて

RNNが扱うのは系列データ(順番が重要なデータ)。

周期データ、累積データも扱うと言えば扱うが

あくまで系列データと見なした上の話となる。

ところで、連鎖データってなんぞ?

イについて

ちょっと悩んだが、消去法で行く。

まず入力を記憶するわけではないので2か4になる。

結果的には「過去のすべての中間層の状態」と言えなくもないが、

RNNの構造としては「前回の中間層の状態」になる。

それに「過去のすべての中間層の状態」を許容すると、

中間層への入力も記憶していることになるので、答えが絞れなくなる。

よって、たぶん2。

ウについて

Recurrent Neural NetworkのRecurrentが再帰という意味。

中間層の前回出力を覚える構造がを指している。

ディープラーニングの手法(5問目)

問題

Q. 通常のニューラルネットワークにはない、畳み込みニューラルネットワークがもつ分類問題の汎化性能の向上に寄与する特徴として、最も適切なものを1つ選べ。

G検定の例題(https://www.jdla.org/certificate/general/issues/)

1. ネットワークの中間層で、再帰的にフィードバックが与えられる。

2. 決定境界を非線形にするために、活性化関数が利用される。

3. 画像全体に対して、一定範囲ごとに入力の特徴量が抽出される。

4. 出力層において、出力が確率に変換される。

解答

3

解説

1について

「再帰的にフィードバックが与えられる」とあるので、これはRNNの説明になる。

2について

「決定境界を非線形にする」は分類のことで、CNNに限らず、全てのニューラルネットワークが持つ特徴になる。

3について

畳み込み層の特徴であり、これがCNNの特徴にもなる。

4について

これは活性化関数のSoftmax関数の話。

ディープラーニングの研究分野(1問目)

問題

Q. 以下の文章の空欄に最もよく当てはまるものを1つずつ選べ。

G検定の例題(https://www.jdla.org/certificate/general/issues/)

ロボティクス分野でも、機械学習の応用が進められている。例えば、ロボットの動作制御にQ学習やモンテカルロ法などの(ア)のアルゴリズムを利用する事例は多く存在する。また、ロボットはカメラ(視覚)、マイク(聴覚)、圧力センサ(触覚)などの異なったセンサ情報を収集できる(イ)システムを持っていることから、これらの情報をDNNで統合的に処理する研究や、ロボットの一連の動作の生成をひとつのDNNで実現しようとする(ウ)の研究も行われている。

(ア)

1. End to End Learning

2. Supervised Learning

3. Motion Learning

4. Adaptive Learning

5. Reinforcement Learning

6. Representation Learning

(イ)

1. マルチモーダル

2. インセプション

3. コグニティブ

4. フルスクラッチ

(ウ)

1. End to End Learning

2. Supervised Learning

3. Motion Learning

4. Adaptive Learning

5. Reinforcement Learning

6. Representation Learning

解答

(ア)5

(イ)1

(ウ)1

解説

アについて

「Q学習」「モンテカルロ法」とあるので、強化学習のことになる。

英語だと「Reinforcement Learning」なので正解は5。

注意点としては「モンテカルロ法」が必ず強化学習と紐づくかというとそうでもなく、

物理シミュレーションの領域でも使用される手法なので、引っかけに使われやすいかも?

イについて

「異なったセンサ情報を収集」したデータを扱うことをマルチモーダルと言う。

対して、1種類のデータを扱う場合はシングルモーダルと言う。

ウについて

「一連の動作の生成をひとつのDNNで実現」とあるので、一気通貫学習のこと。

英語だと「End to End Learning」となる。

DNN(ディープニューラルネットワーク)は深い層を持つため、学習次第では複雑な判定を一括で行うことが可能。

この性質を指してEnd to Endと呼ぶことは多い。

G検定強化学習対策

ディープラーニングの研究分野(2問目)

問題

Q. RNN(Recurrent Neural Network)が自然言語処理の分野で精度の向上に寄与した理由として、最も適しているものを1つ選べ。

G検定の例題(https://www.jdla.org/certificate/general/issues/)

1. 畳み込み層で畳み込み処理を行うことにより、単語の出現位置から文脈を読み取れるようになったため。

2. 隠れ層で過去の情報を保持できるようになり、文字の並びから意味を抽出できるようになったため。

3. ネットワークの外部に記憶部分を設けることで、文章のパターンを簡単に参照できるようになったため。

4. 正しい文章の出力ができるようになるまで繰り返し自動で学習できるようになったため。

解答

たぶん2

解説

1について

畳み込み層を持つことからCNNの説明になる。

一応CNNも1D-CNNというもので文脈を読み取るものはある。

2について

これがRNNの説明。

だとは思うが、「意味を抽出」までをRNNの性能として期待してよいかが謎。

しかし、他の選択肢に適切なものも見当たらないので消去法でこれを解答としている。

3について

RNNは隠れ層に記憶を持つので、「外部に記憶部分を設ける」わけではない。

この説明に該当するモデルとしては「Differentiable Neural Computers」というものがある。

4について

繰り返し自動学習可能なのは機械学習全般の性質で、RNNに限定したものではない。

まとめ

- ディープラーニング初期のCNN系列の有名どころは今でも論文に登場することは多い。

- CNN、RNN、AutoEncoderあたりは基本的なモデルなので特性を覚えておいた方が良い。

- 強化学習周りは用語が多いので少し異なる対策が必要かも。

G検定対策のまとめ記事はこちら。

コメント