LLM(大規模言語モデル)

LLM(Large Language Models)は、自然言語処理の総合力を飛躍的に高めた技術である。膨大なパラメータとデータを用いて学習することで、文章の生成・理解・要約・翻訳など、幅広いタスクに対応可能となった。

現在のAIブームの中心に位置する技術であり、その代表格がGPTシリーズである。

GPT:生成特化型の言語モデル

GPT(Generative Pre-trained Transformer)は、TransformerのDecoder部分を活用したモデルである。「次に来る単語を予測する」ことで文章を生成する構造を持ち、左から右へと順番に処理を行う。

この構造により、自然な文章生成が得意であり、BERTが理解型であるのに対し、GPTは生成型のモデルである。

GPTは、GPT-2 → GPT-3 → GPT-4と進化を重ねており、モデルの規模と性能は年々向上している。例えば、GPT-3は1750億パラメータを持ち、GPT-4ではさらに増加している。学習データもインターネット全体レベルに及び、言語だけでなく、知識や推論まで含まれている。

このような大規模化が、性能向上に直結している。

応用モデル:ChatGPTとPaLM

ChatGPTは、GPTをベースに対話データを追加学習したモデルである。人間らしい応答が可能となるよう調整されており、実用性の高い対話型AIとして広く利用されている。

一方、PaLM(Pathways Language Model)はGoogle系列のLLMであり、Transformerベースの構造を持つ。多言語・多タスクに対応する汎用モデルとして開発されており、GPTとは異なるアプローチで競争を繰り広げている。

このように、LLMはGPTだけでなく、PaLMやClaudeなど、複数のモデルが進化を続けている。

因果関係図における位置づけ

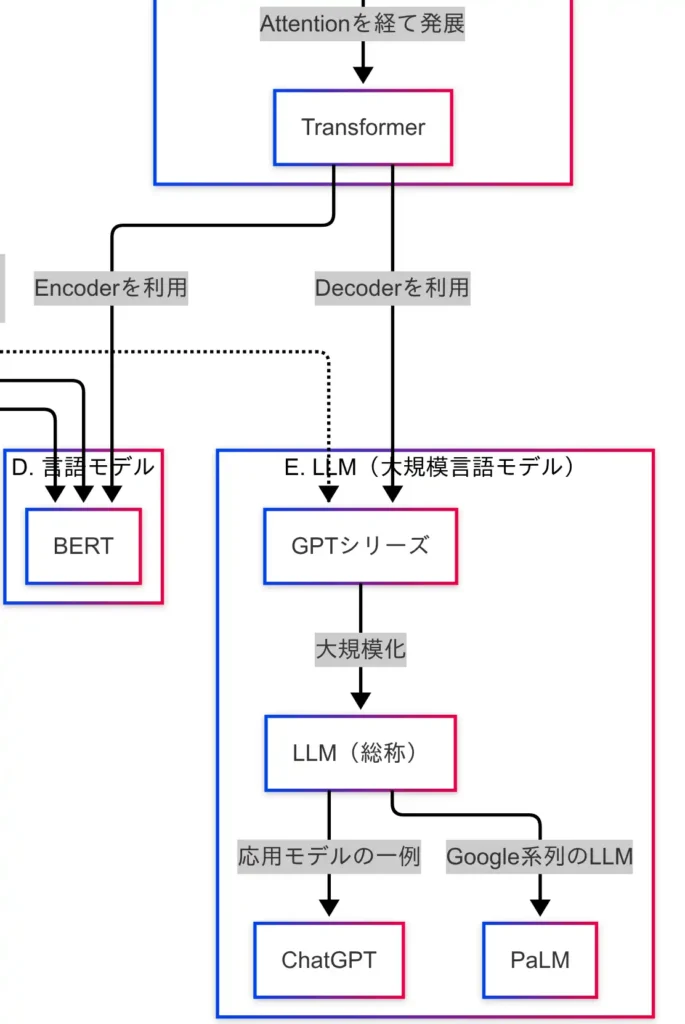

因果関係図を確認すると、TransformerのDecoderがGPTに接続されており、そこからLLM(総称)へと進化し、さらにChatGPTやPaLMなどの応用モデルが派生している。

理解系モデルの評価にはGLUEが用いられるが、GPTのような生成系モデルでは評価軸が異なる点にも留意すべきである。

LLMは、自然言語処理の枠を超え、知識・推論・対話・創造までこなす汎用AIに近づいている技術である。Transformerの力を最大限に引き出した結果が、LLMの登場であり、その進化は今後も続くと考えられる。

GPTをはじめとするLLMは、自然言語処理の可能性を大きく広げており、今や社会のさまざまな場面で活用されている。

応用タスク

自然言語処理(NLP)は、単なる研究対象にとどまらず、実際の業務やサービスに応用されている技術である。本章では、代表的な応用タスクと、それぞれに対応するモデル・手法を整理する。

以下に、主な応用タスクと対応モデルをまとめた。

| 応用タスク | 主なモデル・手法 | 備考 |

|---|---|---|

| 感情分析 | BERT、RoBERTa、LSTM、SVM + TF-IDF | 文の極性(ポジ/ネガ)を分類 |

| 機械翻訳 | Seq2Seq、Transformer、MarianMT、mBART | 多言語対応モデルも多数 |

| 質問応答 | BERT(SQuAD)、ALBERT、T5、ChatGPT | 文脈理解と抽出が重要 |

| 情報検索 | BM25、Dense Retriever(DPR)、ColBERT、RAG | 検索+生成のハイブリッドも |

| 文書要約 | T5、BART、PEGASUS、GPT系 | 抽象型と抽出型の2種類あり |

感情分析

感情分析は、SNSやレビューなどのテキストから、ポジティブかネガティブかといった感情の極性を判定するタスクである。近年では、BERTやRoBERTaといった文脈理解に優れたモデルが主流となっている。かつてはTF-IDFとSVMを組み合わせた古典的手法が多く用いられていたが、現在は深層学習ベースの手法が主流である。

機械翻訳

機械翻訳は、自然言語処理の中でも歴史のある応用分野である。Seq2Seqによって実現され、Transformerの登場により精度が飛躍的に向上した。MarianMTやmBARTのような多言語対応モデルは、1つのモデルで複数言語間の翻訳を可能にしている。

質問応答

質問応答は、単なる情報検索とは異なり、文中から答えそのものを抽出することを目的とするタスクである。BERTはSQuADというデータセットで訓練されており、文脈を理解した上で正確な回答を導き出すことができる。

一方、ChatGPTのようなモデルは、抽出ではなく生成型の質問応答を行う。文脈を踏まえた自然な応答が可能であり、対話型AIとしての応用が進んでいる。

情報検索

情報検索は、関連する文書を探し出すタスクである。BM25のような古典的手法に加え、Dense RetrieverやColBERTといったベクトル検索技術が登場しており、検索精度の向上が図られている。

さらに、RAG(Retrieval-Augmented Generation)のように、検索と生成を組み合わせたハイブリッド型のアプローチも注目されている。

文書要約

文書要約は、長文を短く要約するタスクであり、抽出型(重要文を抜き出す)と抽象型(新たな文を生成する)の2種類が存在する。T5、BART、PEGASUSなどが代表的なモデルであり、GPT系モデルは自然な抽象型要約に強みを持つ。

論文やニュース記事の要約など、実務での活用が進んでいる分野である。

自然言語処理は、感情分析・翻訳・質問応答・検索・要約といった多様な応用タスクを通じて、実社会に深く根ざした技術となっている。それぞれのタスクには特化したモデルが存在し、モデルの構造や学習方法によって得意分野が異なる。

自然言語処理は、もはや専門家だけのものではなく、日常生活やビジネスの現場においても身近な存在となっている。

まとめ

本記事では、自然言語処理の技術体系を因果関係に基づいて整理した。単語の分割から始まり、意味の理解、文の生成、そして実務への応用まで、各技術が連続的に発展していることが明らかとなった。

まずは基盤技術として、形態素解析と構文解析の重要性を確認した。これらは前処理として機能し、精度が低ければ後続の処理すべてに影響を及ぼす。自然言語処理の土台として不可欠な技術である。

次にテキスト表現の進化を辿った。BoWから始まり、TF-IDF、word2vec、ELMo、そしてBERTへと発展してきた。単語の出現頻度を数えるだけの時代から、意味や文脈を捉える時代へと移行している。

モデルアーキテクチャでは、Seq2SeqからAttention、そしてTransformerへの進化が鍵となった。Attentionの導入により文脈理解が飛躍的に向上し、Transformerによって並列処理と精度向上が実現された。

言語モデルの領域では、BERTが文脈理解の代表として登場し、GLUEによる評価を通じてその性能が実証された。文脈を双方向から捉えることで、自然言語理解の精度が大きく向上した。

さらに、LLM(大規模言語モデル)では、GPTシリーズやChatGPT、PaLMなどが登場し、言語モデルの枠を超えた汎用AIとしての可能性が示された。生成能力、知識、推論、対話など、多様な能力を統合したモデルである。

最後に、応用タスクとして、感情分析・機械翻訳・質問応答・情報検索・文書要約など、実務に直結する技術を整理した。それぞれのタスクに特化したモデルが存在し、構造や学習方法によって得意分野が異なる。

自然言語処理の技術は、単なる用語の暗記ではなく、「何を解決するために生まれた技術か」という視点で理解することが重要である。因果関係を意識することで、技術のつながりが明確になり、より深い理解につながる。

バックナンバーはこちら

深層学習教科書 ディープラーニング G検定(ジェネラリスト)公式テキスト 第3版

徹底攻略ディープラーニングG検定ジェネラリスト問題集 第3版 徹底攻略シリーズ

ディープラーニングG検定(ジェネラリスト) 法律・倫理テキスト

コメント