MATLAB、Python、Scilab、Julia比較ページはこちら

https://www.simulationroom999.com/blog/comparison-of-matlab-python-scilab/

はじめに

の、

MATLAB,Python,Scilab,Julia比較 第4章 その90【ユニット数増加⑤】

を書き直したもの。

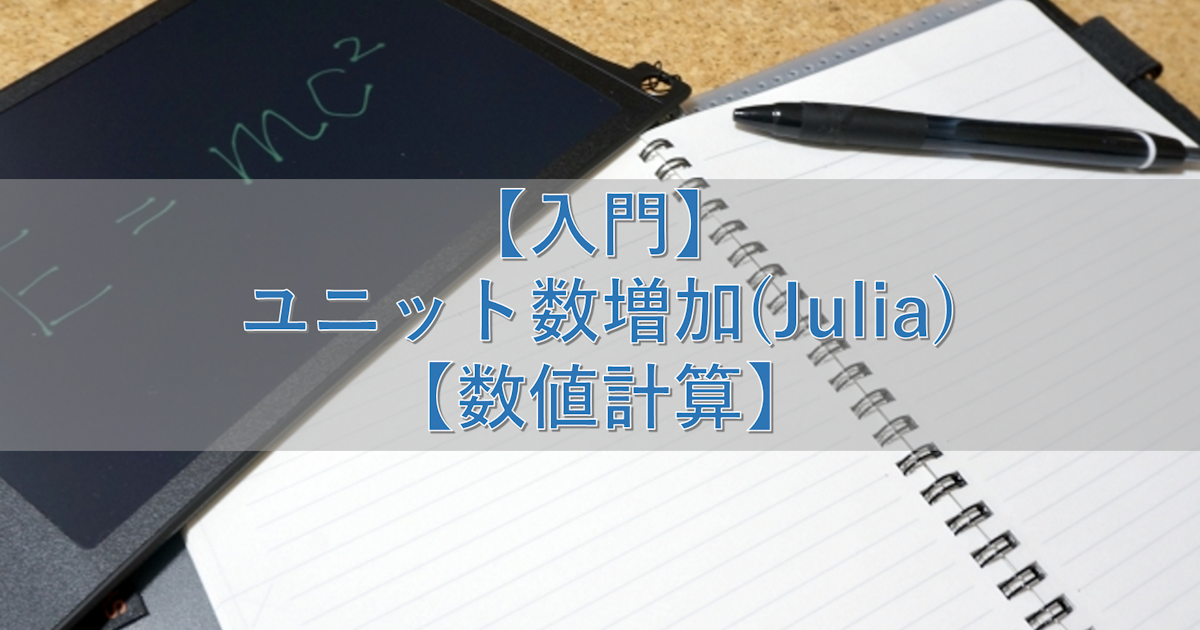

隠れ層のユニット数を増やすことで局所最適解にハマる現象を回避してみる。

今回はJuliaで実現。

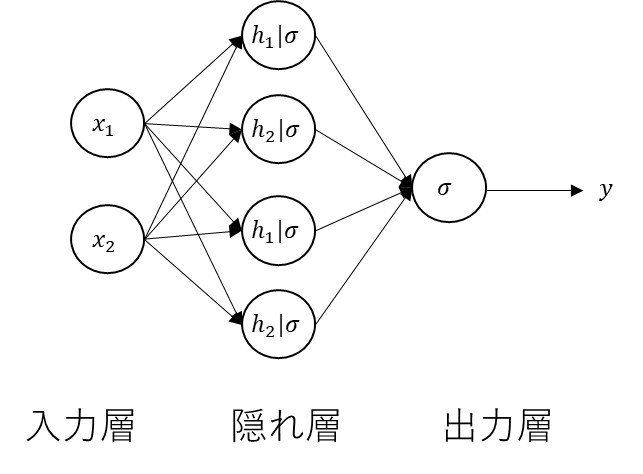

構造と数式【再掲】

隠れ層のユニットを増やした場合の構成を数式を再掲

\(

y=

\sigma\Bigg(

\begin{bmatrix}

w_{211}&w_{212}&w_{213}&w_{214}&b_2

\end{bmatrix}

\begin{bmatrix}

\sigma\bigg(

\begin{bmatrix}

w_{111}&w_{112}&b_1\\

w_{121}&w_{122}&b_1\\

w_{131}&w_{132}&b_1\\

w_{141}&w_{142}&b_1\\

\end{bmatrix}

\begin{bmatrix}

x_1\\x_2\\1

\end{bmatrix}

\bigg)\\

1

\end{bmatrix}

\Bigg)

\)

今回はこれをJuliaで実現する。

Juliaコード

Juliaコードは以下。

using PyPlot

function sigmoid(x)

return 1.0 ./ (1.0 + exp.(-x))

end

function sigmoid_derivative(x)

return sigmoid(x) .* (1.0 - sigmoid(x))

end

function meshgrid(xin,yin)

nx=length(xin)

ny=length(yin)

xout=zeros(ny,nx)

yout=zeros(ny,nx)

for jx=1:nx

for ix=1:ny

xout[ix,jx]=xin[jx]

yout[ix,jx]=yin[ix]

end

end

return (x=xout, y=yout)

end

function MultilayerPerceptron()

# データの準備

X = [0 0; 0 1; 1 0; 1 1] # 入力データ

y = [0; 1; 1; 0] # 出力データ

# ネットワークの構築

hidden_size = 4 # 隠れ層のユニット数

output_size = 1 # 出力層のユニット数

learning_rate = 0.5 # 学習率

input_size = size(X, 2)

W1 = randn(input_size, hidden_size) # 入力層から隠れ層への重み行列

b1 = randn(1, hidden_size) # 隠れ層のバイアス項

W2 = randn(hidden_size, output_size) # 隠れ層から出力層への重み行列

b2 = randn(1, output_size) # 出力層のバイアス項

# 学習

epochs = 4000 # エポック数

errors = zeros(epochs, 1) # エポックごとの誤差を保存する配列

for epoch in 1:epochs

# 順伝播

Z1 = X * W1 .+ b1 # 隠れ層の入力

A1 = sigmoid.(Z1) # 隠れ層の出力

Z2 = A1 * W2 .+ b2 # 出力層の入力

A2 = sigmoid.(Z2) # 出力層の出力

# 誤差計算(平均二乗誤差)

error = (1 / size(X, 1)) * sum((A2 - y) .^ 2)

errors[epoch] = error

# 逆伝播

delta2 = (A2 - y) .* sigmoid_derivative.(Z2)

delta1 = (delta2 * W2') .* sigmoid_derivative.(Z1)

grad_W2 = A1' * delta2

grad_b2 = sum(delta2)

grad_W1 = X' * delta1

grad_b1 = sum(delta1)

# パラメータの更新

W1 = W1 - learning_rate * grad_W1

b1 = b1 .- learning_rate .* grad_b1

W2 = W2 - learning_rate * grad_W2

b2 = b2 .- learning_rate .* grad_b2

end

# 決定境界線の表示

h = 0.01 # メッシュの間隔

x1, x2 = meshgrid(minimum(X[:, 1])-0.5:h:maximum(X[:, 1])+0.5, minimum(X[:, 2])-0.5:h:maximum(X[:, 2])+0.5)

X_mesh = hcat(x1[:], x2[:])

hidden_layer_mesh = sigmoid.(X_mesh * W1 .+ b1)

output_layer_mesh = sigmoid.(hidden_layer_mesh * W2 .+ b2)

y_mesh = round.(output_layer_mesh)

figure()

decision_mesh = reshape(y_mesh, size(x1)) # 分類結果のメッシュを元のグリッドサイズに変形する

colormap = ["#CCFFCC","#FFCCCC"] # 各領域の色を指定する

contourf(x1, x2, decision_mesh, levels=1, colors=colormap)

scatter(X[y .== 1, 1], X[y .== 1, 2], 100, "r", facecolors="none",label="Class 1") # クラス1のデータ点を赤でプロット

scatter(X[y .== 0, 1], X[y .== 0, 2], 100, "g", facecolors="none",label="Class 0") # クラス0のデータ点を緑でプロット

xlabel("X1")

ylabel("X2")

title("XOR Classification")

legend(loc="best") # クラスの順序を入れ替える

grid(true)

show()

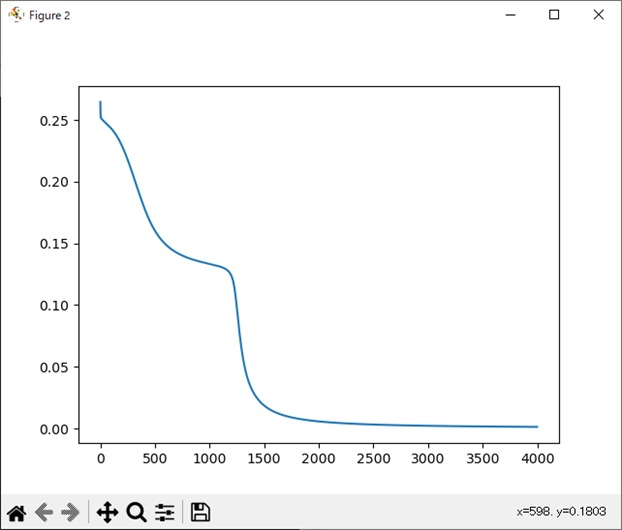

figure()

plot(errors[1:4000])

show()

end

MultilayerPerceptron()処理結果

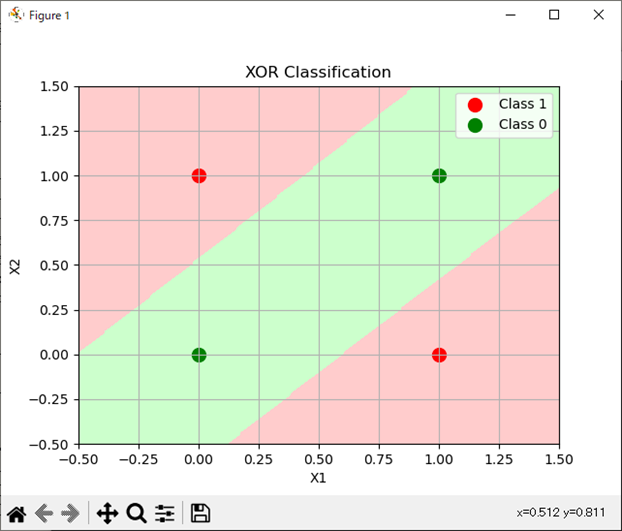

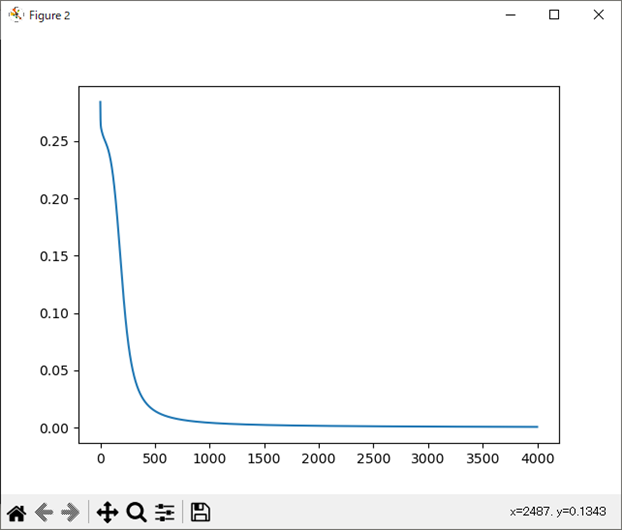

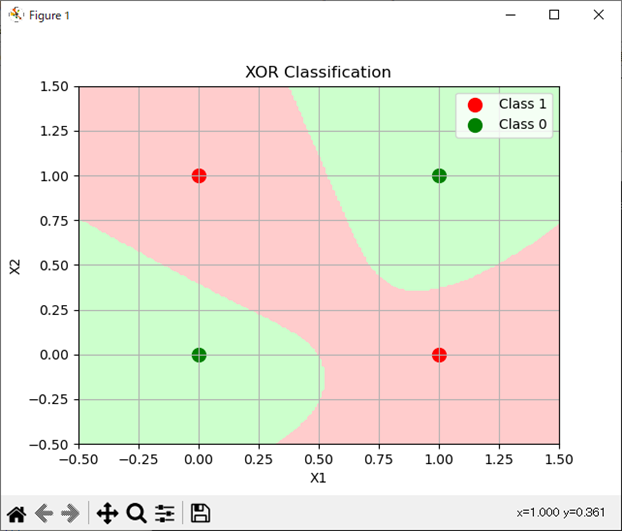

処理結果は以下。

パターン2の方が隠れ層のユニット数を2から4にしたことで出てきた分類パターンになる。

パターン1

パターン2

まとめ

- 多層パーセプトロンの隠れ層のユニット数を2から4に変えたJuliaコードで分類を実施。

- 大きく2パターンの分類パターンがある。

- やや複雑な分類パターンが4ユニットにすることで出てきたもの。

MATLAB、Python、Scilab、Julia比較ページはこちら

Pythonで動かして学ぶ!あたらしい線形代数の教科書

ゼロから作るDeep Learning ―Pythonで学ぶディープラーニングの理論と実装

ゼロからはじめるPID制御

OpenCVによる画像処理入門

恋する統計学[回帰分析入門(多変量解析1)] 恋する統計学[記述統計入門]

Pythonによる制御工学入門

理工系のための数学入門 ―微分方程式・ラプラス変換・フーリエ解析

コメント